隨著5G技術的迅猛發展與廣泛普及,基站業務量的精準預測愈發關鍵。在多基站的場景中,預測工作不僅依賴于各基站自身的歷史業務量信息,還需充分考量基站間的空間聯系及其對預測結果的作用。本文聚焦于多基站情境下的業務量預測問題,探討時間維度和空間維度如何影響基站業務量的預測成效,以期為相關研究與實踐提供有益的參考和借鑒。

基站業務量預測概述

5G基站業務量預測方法成為了一種重要的技術手段,旨在提前感知流量的變化趨勢,從而幫助基站進行資源的合理分配和調整,以滿足用戶的需求。然而多基站業務量預測屬于復雜的時間序列預測任務。時間域方面,傳統的數理統計和機器學習模型,在提取業務量數據特征的能力有限。近年來,深度學習模型因為擅長處理非線性數據,所以被開發應用于時間序列任務中。但卷積神經網絡(CNN)卷積層的局部感知能力需要在模型中設置多層卷積和池化操作,通常難以捕捉長期依賴關系。循環神經網絡(RNN)類的模型存在梯度爆炸和無法在硬件顯卡中并行訓練的問題。此外,在空間域方面,5G基站的業務量數據表現出明顯的區域性特征。

圖1 不同地區5G基站業務量的走勢圖

如圖 1 所示,我們獲取了來自高鐵站、住宅區、高校等多個區域的真實 5G 基站業務量數據,并繪制出相應的業務量走勢圖。經分析發現,某高速路段的 5G 基站業務量呈現出顯著的潮汐特性,其波峰與波谷的數值差異頗為顯著。與之相對,某小區的 5G 基站業務量走勢較為平穩緩和,并且在趨勢上與高速基站的業務量走勢表現出一定的趨同性。另外,公園區域的 5G 基站業務量數據中,波峰和波谷的出現時間相對更早。基于以上的分析,我們利用基站之間在空間上的相關性,進一步提高模型的預測精度。

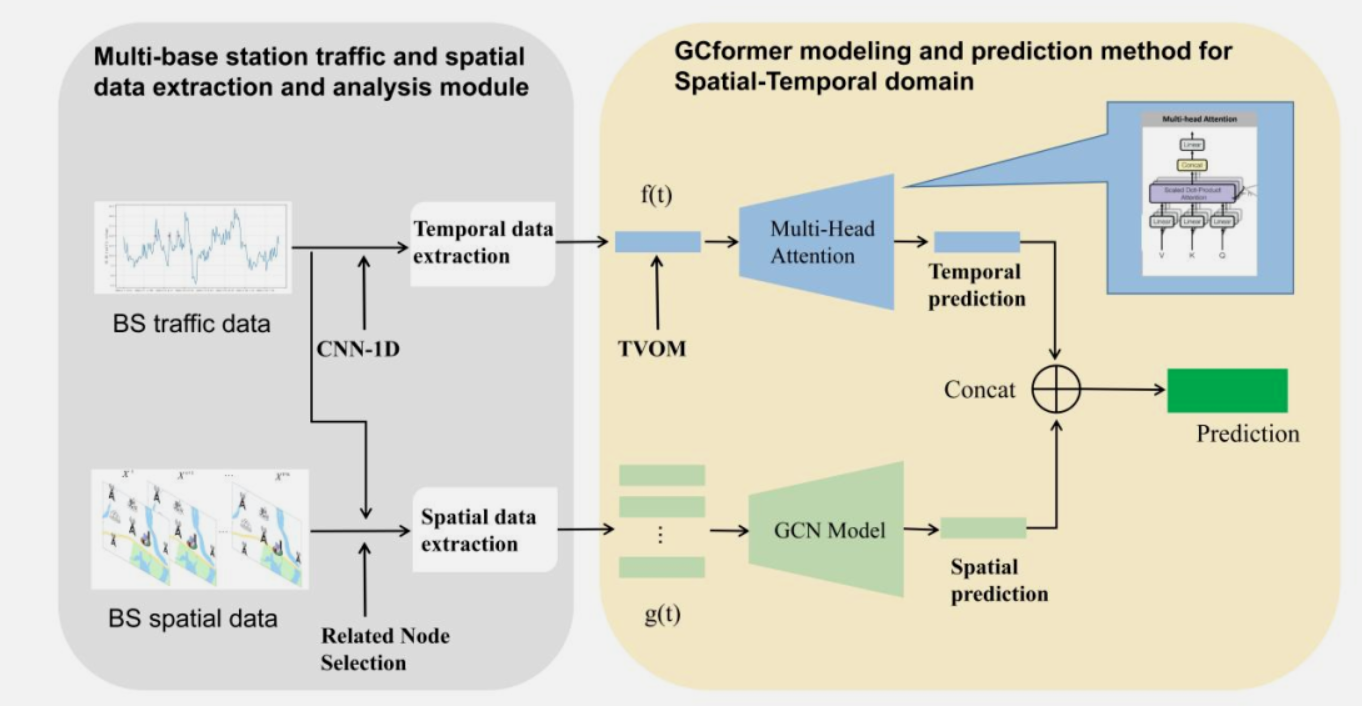

GCformer時空預測模型

我們描述如何使用GCFormer模型來對5G基站的業務量進行預測,模型由空域和時間域兩個子模塊組成,如圖2所示。空間域方面,我們根據多基站的工參和業務量數據對相關基站節點選擇,得到鄰接矩陣的空間數據。之后我們使用圖卷積神經網絡(Graph Convolutional Networks, GCN)模型提取基站網絡的空間關聯結構。時域方面我們將多基站的歷史業務量數據,通過1D-CNN模塊提取歷史數據的時間段信息,其次將得到的數據輸入到Transformer模型中。并且在Transformer的位置編碼的分,我們通過TVOM(Time Variant Optimization Module)方法加入了周期項信息,提高模型捕獲時序關系的能力。最后我們將時空兩模塊的輸出特征進行融合,得到模型的預測結果。

圖2. GCformer系統模型,包括通過1D-CNN和TVOM模塊改進的Transformer類模型和通過基站節點選擇并基于GCN模型的空間信息提取部分

圖卷積神經網絡和相關基站節點選擇

圖神經網絡(Graph Neural Networks,GNN)是一種處理圖數據的深度學習模型。與CNN, RNN等傳統的深度學習模型不同,它能夠處理非歐幾里德空間的數據,對節點和邊進行信息傳遞和學習,從而對整個圖進行綜合建模和分析。

圖卷積神經網絡(GCN)是 GNN 中的一種。相比于傳統的 GNN,GCN 利用圖形結構的信息,在節點卷積操作中使用鄰接矩陣和度矩陣進行特征聚合,從而提取節點的高層次特征表示,反映出基站間復雜的網絡拓撲結構,進一步準確地捕捉空間相關性。具體來說GCN 的核心就是在圖形數據上定義卷積層。與傳統的卷積神經網絡不同,GCN 中的卷積層旨在利用圖形結構,從相鄰節點的信息中汲取有效的特征,而關系越親近的鄰居對當前節點的影響就越大。

在構建5G基站的鄰接矩陣時,選擇合適的基站節點是至關重要的,這不僅影響數據的準確性,還關系到網絡優化的效果。基于此,我們運用三種方法來構建鄰接矩陣:一是歐式距離法,即通過計算兩基站間的直線距離衡量其物理接近程度,此為評估地理位置相近基站關系的基本方法;二是區域類型法,鑒于基站所處區域類型(如商業區、學校區、住宅區等)會對其業務量特性產生重要影響,故而依據區域類型將功能或位置相似的基站分組,以此明晰基站間的異同;三是業務量相似性法,借助余弦相似度、聚類等手段對基站間業務量數據展開分析,基于數據驅動從多維度揭示基站在業務量上的相似或差異情況,助力基站網絡的理解與分析。

時間域模型和時變優化模塊

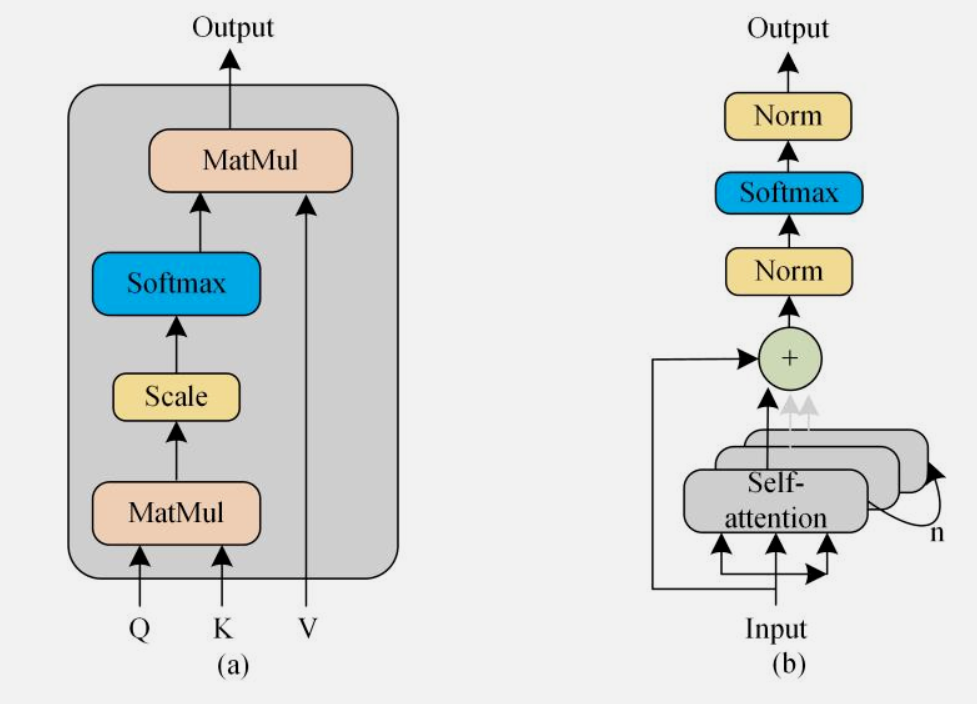

Transformer模型是一種應用于序列建模的神經網絡模型,因為其內部的Self-Attention機制以及Positional Encoding方法,使得該模型在文本摘要、語言翻譯等自然語言處理任務中取得了優異的成績。近年來,Transformer模型也被廣泛應用其他領域的序列建模和預測任務。而5G基站業務量預測是一個時間序列預測任務,其中每個時間窗口都對應著基站的一段實際業務量。因此,Transformer 模型可以被用來對5G基站的業務量進行建模和預測,為相關的業務決策提供參考和依據。

圖3 Self-Attention and Multi-head attention

此外,傳統的Transformer模型根據輸入數據位置的不同,通過Positional Encoding的方法增加輸入數據之間的順序關系。但是這種絕對位置編碼的方法,在處理5G基站業務量數據時,缺乏可靠且針對性的時間序列的分析。因此,我們提出Time Variant Optimization Module(TVOM)增加Transformer模型中的時序信息。TVOM通過計算數據中的相關性,來提取5G基站小區的業務量數據的周期項信息,并將周期數據加入到Positional Encoding部分。

具體來說,我們利用Prophet模型分析5G基站用戶數業務量數據,提取出具體的周期性信息。隨后我們通過最小二乘法進行曲線擬合,該方法將設計的曲線數據和實際數據的誤差作為目標函數,對擬合的曲線進行優化。通過最小化誤差的平方值,來獲得最優的多項式的系數,進而構造出周期項對應的的函數表達式。在訓練模型的過程中,將小區ID作為匹配標簽,根據輸入數據的起始時刻對應替換周期項函數。從而彌補原始的Positional Encoding方法無法在時間序列數據中表示不足的問題。

總結

在這項研究中,我們根據5G基站業務量數據的時空特性,提出了一個深度學習架構GCformer。為了有效地描述多個基站之間空間相關性的關系,我們選取了基站距離、區域類型、數據相似度建立綜合信息的鄰接矩陣,并使用GCN模塊提取其空間關系。此外GCformer的時間域模塊繼承了Transformer模型,使用Self-Attention方法提取業務量數據之間的關系,并且通過1D-CNN和TVOM模塊進一步提升捕獲數據中的時序信息。